Masinõppe mudelite rakendatavust ja kasutatavust testitakse andmetel. Testide usaldusväärsus sõltub suuresti andmete kogusest ja kvaliteedist, millele neid mudeleid rakendatakse. See on omaette täielik ülesanne luua, hankida ja puhastada sobivalt suur andmestik, et testida oma ' Loomuliku keele töötlemine (NLP) ”Masinõppe mudel.

Hugging Face pakub selleks kena lahendust oma erakordselt suure andmekogumitega, mille hulgast valida ja leida just see, mis sobib ideaalselt teie vajadustega. Siin näitame teile, kuidas leida ideaalne andmestik ja valmistada see ette oma mudeli adekvaatseks testimiseks.

Kuidas kasutada kallistava näo andmekogumeid?

Näitame teile, kuidas kasutada kallistava näo andmekogumeid, kasutades näidet ' Väikesed lood ” Andmekogum Hugging Face'ist.

Näide

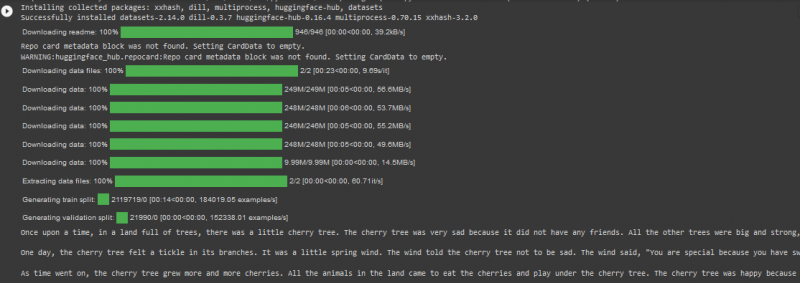

TinyStories Datasetis on rongijaotuses rohkem kui 2 miljonit andmerida ja Hugging Face platvormil on seda allalaaditud rohkem kui 2 tuhat. Kasutame seda allpool toodud Google Colabi koodis:

! pip installida trafod

! pip installida andmestikud

andmekogumitest import load_dataset

andmestik = load_dataset ( 'roneneldan / TinyStories' )

TinyStories_Story = 3

example_string = andmestik [ 'rong' ] [ TinyStories_Story ] [ 'tekst' ]

printida ( näide_string )

Selles koodis kaaluge alltoodud samme:

Samm 01 : Esimene samm on ' paigaldus trafode andmekogumitest.

Samm 02 : järgmiseks importige vajalik andmestik, ' Väikesed lood ” oma projekti.

Samm 03 : järgmiseks laadige valitud andmestik, kasutades nuppu ' load_dataset() ” funktsioon.

Samm 04 : Nüüd määrame loo numbri, mida tahame TinyStoriesi andmestikust. Oleme oma koodinäites määranud numbri 03.

Samm 05 : Lõpuks kasutame väljundi kuvamiseks meetodit 'print()'.

Väljund

Märge: Koodi ja väljundit saab vaadata ka otse meie Google Colabis .

Järeldus

“ Kallistava näo andmestikud ” muudab kasutajatele oma masinõppemudelite testimise uskumatult tõhusaks, importides samal ajal suuri andmekogusid otse oma veebiteegist. Selle tulemusena on NLP-algoritmide rakendamine muutunud lihtsamaks ja kiiremaks, kuna programmeerijad saavad lasta oma projekte testida nii kvaliteedi kui ka kvantiteediga andmekogumiga.