Hugging Face'i andmekogumite teek pakub mugavat viisi loomuliku keele töötlemise ülesannete jaoks andmekogumitega töötamiseks ja nendega manipuleerimiseks. Üks kasulik funktsioon, mida teegi pakub, on concatenate_datasets(), mis võimaldab liita mitu andmestikku üheks andmekogumiks. Järgnevalt on lühike ülevaade funktsioonist concatenate_datasets() ja selle kasutamisest.

concatenate_datasets()

Kirjeldus:

Hugging Face'i andmekogude teek pakub funktsiooni concatenate_datasets(). Seda kasutatakse mitme andmekogumi ühendamiseks, ühendades need kindlaksmääratud teljel üheks andmestikuks. See funktsioon on eriti kasulik, kui teil on mitu andmestikku, millel on sama struktuur, ja soovite need edasiseks töötlemiseks ja analüüsiks liita ühtseks andmekogumiks.

Süntaks:

alates andmestikud importida andmekomplektide ühendamine

konkateneeritud_andmekogum = andmekomplektide ühendamine ( andmestikud , telg = 0 , info = Mitte ühtegi )

Parameetrid:

andmestikud (andmestiku loend): andmestike loend, mida soovite ühendada. Nendel andmekogumitel peavad olema ühilduvad funktsioonid, mis tähendab, et neil on sama skeem, veergude nimed ja andmetüübid.

telg (int, valikuline, vaikimisi = 0): telg, mida mööda tuleks konkateneerida. Enamiku NLP andmekogumite puhul kasutatakse vaikeväärtust 0, mis tähendab, et andmestikud on ühendatud vertikaalselt. Kui määrate telje = 1, ühendatakse andmestikud horisontaalselt, eeldades, et neil on funktsioonidena erinevad veerud.

info (datasets.DatasetInfo, valikuline): teave ühendatud andmestiku kohta. Kui seda pole esitatud, tuletatakse teave loendi esimesest andmekogumist.

Tagastab:

konkateneeritud_andmekogum (Andmekogum): saadud andmestik pärast kõigi sisendandmete kogumite ühendamist.

Näide:

# 1. samm: installige andmekogumite teek# Saate selle installida pipi abil:

# !pip installi andmestikku

# 2. samm: importige vajalikud teegid

alates andmestikud importida load_dataset , andmekomplektide ühendamine

# 3. samm: laadige IMDb filmiülevaate andmekogumid

# Kasutame kahte IMDb-andmestikku, ühte positiivsete arvustuste jaoks

#ja teine negatiivsete arvustuste jaoks.

# Laadige 2500 positiivset arvustust

dataset_pos = load_dataset ( 'imdb' , poolitatud = 'rong[:2500]' )

# Laadige 2500 negatiivset arvustust

dataset_neg = load_dataset ( 'imdb' , poolitatud = 'rong[-2500:]' )

# 4. samm: ühendage andmestikud

# Ühendame mõlemad andmestikud piki telge=0, nagu neil on

sama skeem ( samad omadused ) .

konkateneeritud_andmekogum = andmekomplektide ühendamine ( [ dataset_pos , dataset_neg ] )

# 5. samm: analüüsige ühendatud andmekogumit

# Lihtsuse huvides loendame positiivsete ja negatiivsete arvu

# arvustust ühendatud andmekogumis.

positiivsete_arvustuste arv = summa ( 1 jaoks silt sisse

konkateneeritud_andmekogum [ 'silt' ] kui silt == 1 )

negatiivsete_arvustuste arv = summa ( 1 jaoks silt sisse

konkateneeritud_andmekogum [ 'silt' ] kui silt == 0 )

# 6. samm: kuvage tulemused

printida ( 'Positiivsete arvustuste arv:' , positiivsete_arvustuste arv )

printida ( 'Negatiivsete arvustuste arv:' , negatiivsete_arvustuste arv )

# 7. samm: printige ühendatud andmestikust mõned näited arvustused

printida ( ' \n Mõned arvustuste näited:' )

jaoks i sisse ulatus ( 5 ) :

printida ( f 'Ülevaade {i + 1}: {concatenated_dataset['text'][i]}' )

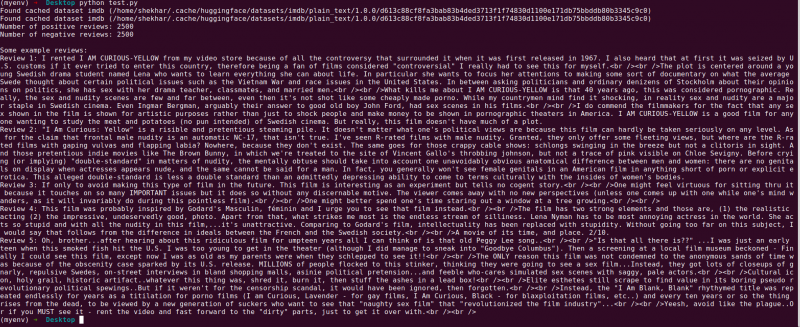

Väljund:

Järgmine on Hugging Face'i 'andmekogumite' teegiprogrammi selgitus, mis ühendab kaks IMDb filmiülevaate andmekogumit. See selgitab programmi eesmärki, selle kasutamist ja koodiga seotud samme.

Anname üksikasjalikuma selgituse koodi iga sammu kohta:

# 1. samm: importige nõutavad teegidalates andmestikud importida load_dataset , andmekomplektide ühendamine

Selles etapis impordime programmi jaoks vajalikud teegid. IMDb filmiülevaate andmekogumite laadimiseks vajame funktsiooni „load_dataset” ja nende hilisemaks ühendamiseks funktsiooni „concatenate_datasets”.

# 2. samm: laadige IMDb filmi ülevaate andmestikud# Laadige 2500 positiivset arvustust

dataset_pos = load_dataset ( 'imdb' , poolitatud = 'rong[:2500]' )

# Laadige 2500 negatiivset arvustust

dataset_neg = load_dataset ( 'imdb' , poolitatud = 'rong[-2500:]' )

Siin kasutame funktsiooni „load_dataset”, et tuua kaks IMDb-andmestiku alamhulka. 'Dataset_pos' sisaldab 2500 positiivset arvustust ja 'dataset_neg' sisaldab 2500 negatiivset arvustust. Kasutame jagatud parameetrit, et määrata laaditavate näidete vahemik, mis võimaldab meil valida kogu andmestiku alamhulga.

# 3. samm: ühendage andmestikudkonkateneeritud_andmekogum = andmekomplektide ühendamine ( [ dataset_pos , dataset_neg ] )

Selles etapis ühendame IMDb-andmestiku kaks alamhulka üheks andmestikuks nimega 'concatenated_dataset'. Kasutame funktsiooni 'concatenate_datasets' ja edastame selle loendiga, mis sisaldab kahte ühendatavat andmestikku. Kuna mõlemal andmestikul on samad omadused, ühendame need piki telg=0, mis tähendab, et read on virnastatud üksteise peale.

# 4. samm: analüüsige ühendatud andmekogupositiivsete_arvustuste arv = summa ( 1 jaoks silt sisse

konkateneeritud_andmekogum [ 'silt' ] kui silt == 1 )

negatiivsete_arvustuste arv = summa ( 1 jaoks silt sisse

konkateneeritud_andmekogum [ 'silt' ] kui silt == 0 )

Siin teostame ühendatud andmestiku lihtsa analüüsi. Positiivsete ja negatiivsete arvustuste loendamiseks kasutame loendi mõistmist koos funktsiooniga 'summa'. Kordame läbi “ silt' veerus 'concatenated_dataset' ja suurendage arvu alati, kui kohtame positiivset silti (1) või negatiivset silti (0).

# 5. samm: kuvage tulemusedprintida ( 'Positiivsete arvustuste arv:' , positiivsete_arvustuste arv )

printida ( 'Negatiivsete arvustuste arv:' , negatiivsete_arvustuste arv )

Selles etapis prindime oma analüüsi tulemused – positiivsete ja negatiivsete arvustuste arvu ühendatud andmekogumis.

# 6. samm: printige mõned näitedprintida ( ' \n Mõned arvustuste näited:' )

jaoks i sisse ulatus ( 5 ) :

printida ( f 'Ülevaade {i + 1}: {concatenated_dataset['text'][i]}' )

Lõpuks tutvustame paar näidet koondatud andmekogumist. Vaatame andmestiku esimesed viis näidet läbi ja prindime nende tekstisisu veeru „tekst” abil.

See kood näitab otsest näidet Hugging Face'i 'andmekogumite' teegi kasutamisest IMDb filmiülevaate andmekogumite laadimiseks, ühendamiseks ja analüüsimiseks. See tõstab esile raamatukogu võimet sujuvamaks muuta NLP-andmekogumi käsitlemist ja näitab selle potentsiaali keerukamate loomuliku keele töötlemise mudelite ja rakenduste loomiseks.

Järeldus

Pythoni programm, mis kasutab Hugging Face'i 'andmekogumite' teeki, demonstreerib edukalt kahe IMDb filmiülevaate andmestiku ühendamist. Laadides positiivsete ja negatiivsete arvustuste alamhulgad, ühendab programm need üheks andmestikuks, kasutades funktsiooni concatenate_datasets(). Seejärel teeb see lihtsa analüüsi, loendades kombineeritud andmekogumis positiivsete ja negatiivsete arvustuste arvu.

'Andmekogumite' teek lihtsustab NLP andmekogumite käitlemise ja manipuleerimise protsessi, muutes selle teadlaste, arendajate ja NLP praktikute jaoks võimsaks tööriistaks. Oma kasutajasõbraliku liidese ja laiaulatuslike funktsioonidega võimaldab raamatukogu hõlpsat andmete eeltöötlust, uurimist ja teisendamist. Selles dokumentatsioonis tutvustatud programm on praktiline näide selle kohta, kuidas raamatukogu saab andmete ühendamise ja analüüsi ülesannete sujuvamaks muutmiseks kasutada.

Reaalses elus võib see programm olla aluseks keerukamatele loomuliku keele töötlemise ülesannetele, nagu tundeanalüüs, teksti klassifitseerimine ja keele modelleerimine. 'Andmekogumite' teeki kasutades saavad teadlased ja arendajad tõhusalt hallata suuremahulisi andmekogumeid, hõlbustada katsetamist ja kiirendada tipptasemel NLP mudelite väljatöötamist. Üldiselt on Hugging Face 'andmekogumite' raamatukogu oluline väärtus loomuliku keele töötlemise ja mõistmise edusammude taotlemisel.